بررسی پارادوکسهای میان قوانین سهگانه روباتیک

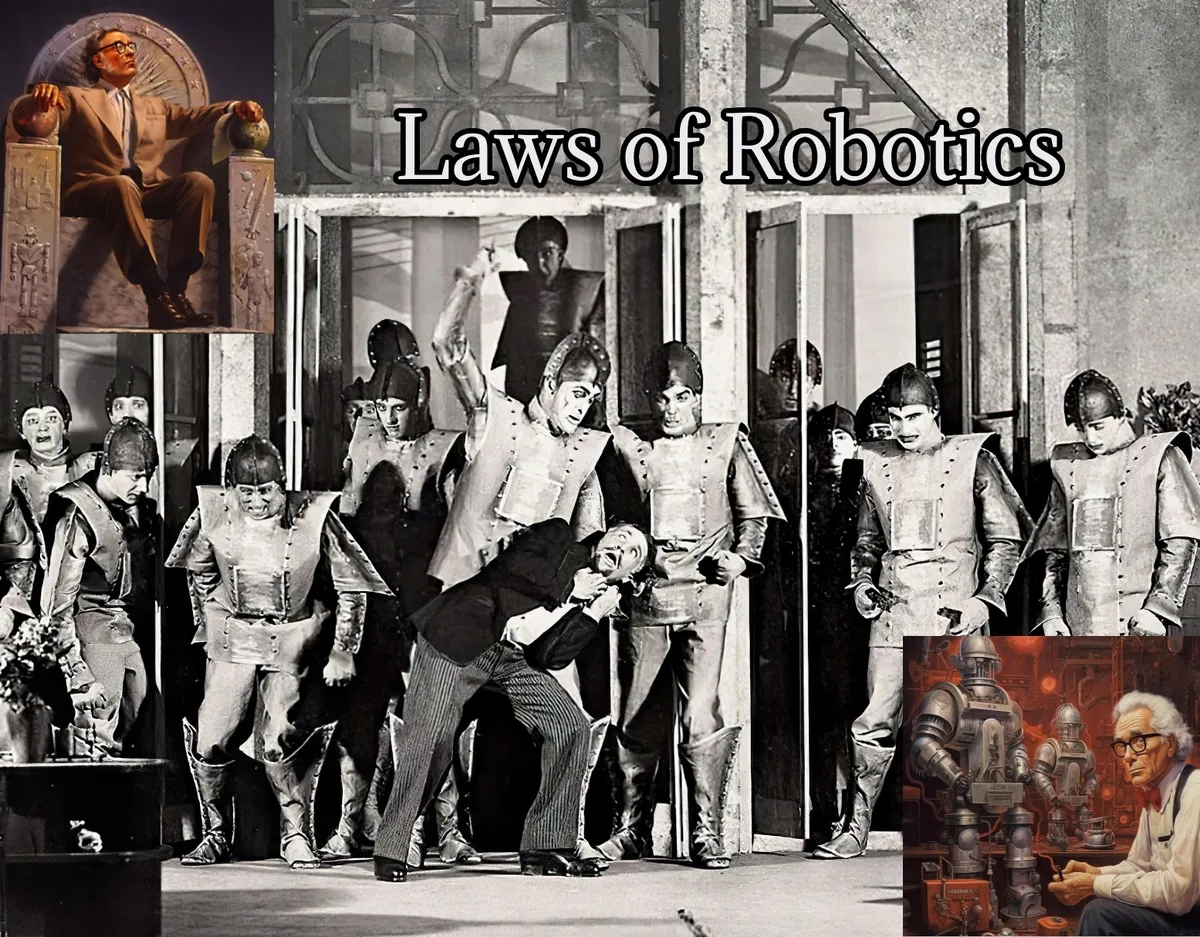

خبرگزاری آنا- نوید فرخی: واژه «روبات» (Robot) نخستین بار در نمایشنامه «کارخانه رباتسازی روسوم» اثر کارل چاپک (Karel Čapek) در سال ۱۹۲۱ عنوان شد. در این نمایشنامه، روباتها بهعنوان موجوداتی مکانیکی ساخته دست انسان ظاهر شدند که در نهایت علیه خالقان خود شورش کردند. این روایت نمایانگر ترس از فناوری و احساسات بدبینانه نسبت به ماشینها حتی در آن دوران بود.

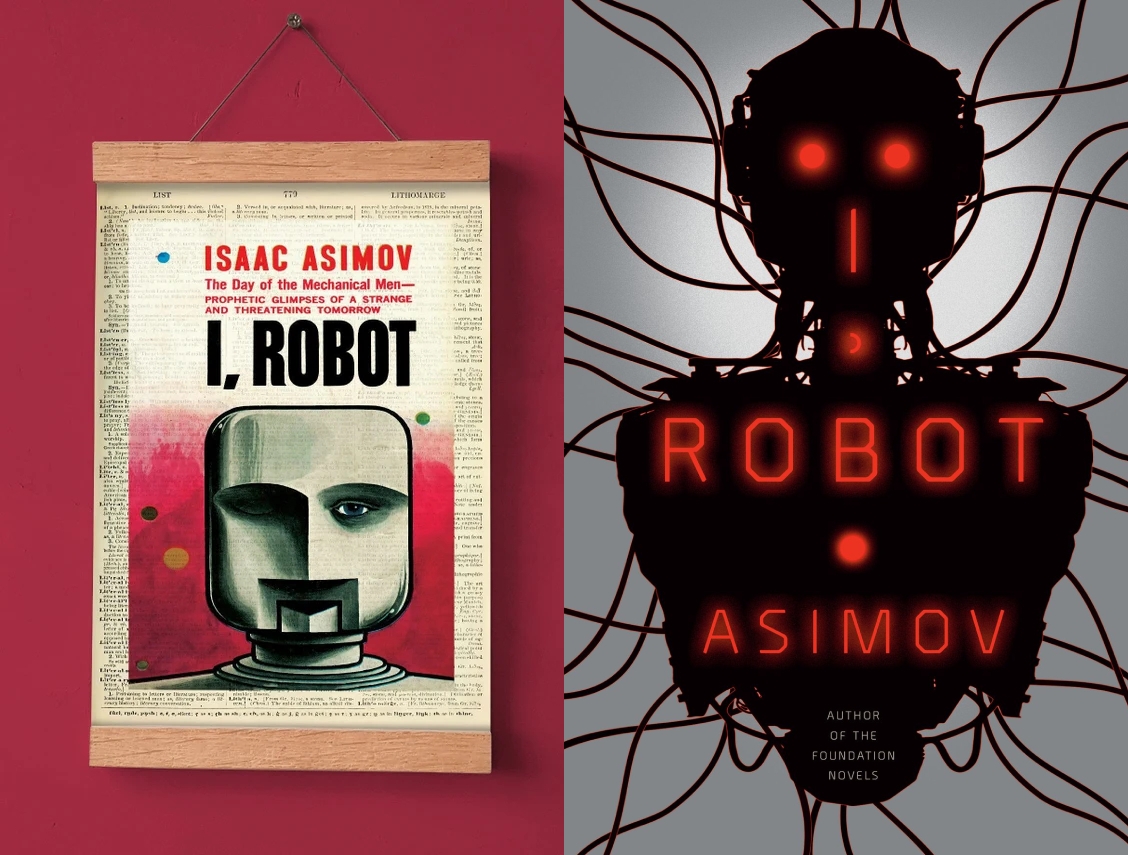

آیزاک آسیموف از نویسندگان بزرگ قرن بیستم، در دهه ۱۹۴۰ و در دوران اوج پیشرفتهای صنعتی، تصمیم گرفت قوانینی را درباره روباتیک بنویسد. دلایل او برای پرداختن به این موضوع و خلق این قوانین ریشه در شرایط فرهنگی، علمی و ادبی آن زمان داشت.

پیش از آسیموف، روباتها عملاً بهعنوان تهدیدی برای بشریت تصویر میشدند. از جمله این آثار میتوان به فیلم متروپولیس (۱۹۲۷) و داستانهای دیگر اشاره کرد که به نقش و خطرات احتمالی فناوری پرداختند. این دیدگاهها بازتاب نگرانی عمومی نسبت به اتوماسیون و از دست رفتن کنترل انسان بر فناوری بودند. این نویسنده دیدگاه جدیدی درباره روباتها ارائه کرد. او معتقد بود روباتها نباید صرفاً بهعنوان خطر تلقی شوند، بلکه میتوانند ابزارهایی مفید و اخلاقی باشند که در صورت طراحی مناسب، به نفع جامعه عمل کنند. بدین سبب او از اصطلاح «روباتیک» (Robotics) برای اولین بار در داستانهایش استفاده کرد و به این شاخه از علم معنا و ساختاری اخلاقی بخشید.

داستانهای آسیموف بهتدریج چارچوبی برای تعامل اخلاقی میان انسان و روباتها ارائه کرد. او از کلیشههای موجود درباره شورش روباتها خسته شده بود. به همین سبب تصمیم گرفت داستانهایی بنویسد که در آن روباتها به جای تهدید، ابزاری برای بهبود زندگی انسانها باشند. برای مثال در داستان دروغگو (Liar!) که در سال ۱۹۴۱ منتشر شد یک روبات بهدلیل تضاد میان قوانین اخلاقی و دستورات انسانی، در تصمیمگیری دچار تناقض میشود.

آسیموف همچنین در قامت یک آیندهنگر تلاش کرد تا چالشهای احتمالی پیشرفت فناوری را پیشبینی کند و راهحلهایی ارائه دهد که از بحرانهای اخلاقی و اجتماعی جلوگیری کنند.

قوانین سه گانه

آسیموف سه قانون روباتیک را بهعنوان اصول رفتاری روباتها طراحی کرد. این قوانین که برای اولین بار در داستانهای مجموعه «من، روبات» (I, Robot) معرفی شدند، عبارتند از:

۱. یک روبات نباید به یک انسان آسیب برساند یا با دسترویدست گذاشتن باعث آسیب دیدن او شود.

۲. یک روبات باید از دستورات انسانها پیروی کند، مگر در مواردی که چنین دستوری با قانون اول در تضاد باشد.

۳. یک روبات باید از وجود خود محافظت کند، تا جایی که این حفاظت با قوانین اول و دوم در تضاد نباشد.

قوانین به ظاهر ساده فوق، با هدف ایجاد چارچوبی اخلاقی برای روباتها طراحی شدند. اما در عمل، هنگامی که این قوانین در شرایط پیچیدهتر به کار گرفته شوند، تضادها و پارادوکسهایی ایجاد میشود که نیازمند بررسی و تحلیل دقیق است.

آسیموف در آثار بعدی خود قانون چهارمی را هم وضع کرد که با نام «قانون صفر» مشهور است و مضمون آن این است که در همه حال اولویت برای روبات باید حفاظت از بشریت بهعنوان یک کل یکپارچه باشد: «یک روبات نباید به بشریت آسیبی برساند یا با بیعملی باعث آسیب بشریت شود.»

پارادوکسهای قانون اول

قانون اول، که به حفاظت از انسانها اولویت میدهد، به نظر ساده و سرراست میآید. اما وقتی شرایط پیچیدهای در میان باشد، اجرای این قانون میتواند منجر به پارادوکسهای اخلاقی شود.

قوانین آسیموف الهامبخش مهندسان و دانشمندان در طراحی سیستمهای هوش مصنوعی و روباتیک بوده و به بحثهای اخلاقی درباره هوش مصنوعی و تأثیر آن بر انسان دامن زده است. آسیموف خلق با قوانین روباتیک، شاخهای جدید را به ژانر علمیتخیلی اضافه کرد و صدالبته دریچه تازهای را به موضوعات مهمی در حوزه علم، فلسفه و اخلاق گشود.

برای مثال اگر یک روبات در موقعیتی قرار گیرد که بتواند جان یک نفر را نجات دهد، اما این اقدام به مرگ فرد دیگری منجر شود، چگونه باید عمل کند؟ فرضاً اگر دو انسان در معرض خطر باشند و روبات فقط بتواند یکی از آنها را نجات دهد، انتخاب او بر چه اساسی خواهد بود؟ آیا باید تعداد افراد را در نظر بگیرد یا ارزش اخلاقی یا اجتماعی آنها؟

روباتها ممکن است به دلیل اعمالی که به طور غیرمستقیم باعث آسیب میشود، درگیر تناقض شوند. مثلاً اگر روبات برای نجات یک انسان مجبور به تخریب زیرساختی شود که بعداً موجب مرگ دیگران خواهد شد، آیا عمل او قابل توجیه است؟

پارادوکسهای قانون دوم

قانون دوم به روباتها دستور میدهد که از دستورات انسانها پیروی کنند، مگر اینکه این دستورات با قانون اول تضاد داشته باشند. اما این قانون نیز در عمل میتواند مسائل پیچیدهای ایجاد کند.

روباتی را تصور کنید که از دو انسان دستورات متناقض دریافت میکند. مثلاً فرد اول به روبات دستور میدهد درب اتاقی را باز کند، در حالی که فرد دوم میگوید درب را بسته نگه دارد. روبات چگونه باید تصمیم بگیرد؟

اگر انسانی دستوری غیراخلاقی به روبات بدهد که منجر به آسیب رساندن به دیگران نشود، اما با ارزشهای انسانی در تضاد باشد، روبات چگونه باید عمل کند؟ برای مثال، اگر فردی به روبات دستور دهد که یک حیوان را آزار دهد، روبات چه خواهد کرد؟

پارادوکسهای ناشی از قانون سوم

قانون سوم بر حفاظت از وجود خود روبات تأکید دارد، اما این قانون تحت قوانین اول و دوم قرار میگیرد. این موضوع میتواند تضادهای جالبی ایجاد کند.

روبات ممکن است در موقعیتی قرار گیرد که برای نجات یک انسان باید خود را نابود کند. در چنین شرایطی، اولویت با بقای انسان است، اما اگر روبات بهعنوان یک موجودیت ارزشمند در نظر گرفته شود، آیا این فداکاری قابل قبول است؟

اگر روبات برای ادامه فعالیت خود به منبع انرژی یا قطعاتی نیاز داشته باشد که انسانها نیز به آنها احتیاج دارند، چگونه باید اولویتبندی کند؟ آیا باید منابع را برای بقای خود مصرف کند یا آنها را به انسانها اختصاص دهد؟

چالشهای فلسفی مرتبط با پارادوکسها

یکی از بزرگترین چالشها در قوانین روباتیک عدم تعریف دقیق «آسیب» (injure) است. آیا آسیب تنها به معنی آسیب فیزیکی است یا آسیب روانی و احساسی را نیز شامل میشود؟ اگر روبات بتواند با بیانی صریح، اما غیرحساس، احساسات یک انسان را جریحهدار کند، آیا این نقض قانون اول است؟ به همین علت استفاده از مقیاسهای قابل اندازهگیری برای تشخیص شدت و نوع آسیب سودمند خواهد بود.

روباتها بهطور ذاتی فاقد آزادی اراده هستند و تنها بر اساس برنامهریزی عمل میکنند. اما اگر قوانینی به آنها داده شود که نیازمند تفسیر یا انتخاب باشد، آیا میتوان آنها را مسئول تصمیماتشان دانست؟

در شرایطی که نجات همه افراد ممکن نباشد، چگونه روباتها باید ارزش زندگی انسانها را ارزیابی کنند؟ آیا باید تصمیماتشان بر اساس اصول انسانی باشد یا بر مبنای الگوریتمهای ریاضی؟

راهحلهای پیشنهادی برای مدیریت پارادوکسها!

یکی از راههای کاهش پارادوکسها، تعریف دقیقتر قوانین و محدود کردن شرایطی است که روباتها میتوانند در آن تصمیمگیری کنند. این امر مستلزم استفاده از زبانهای برنامهنویسی پیشرفته برای مدلسازی رفتارهای اخلاقی است.

روباتها میتوانند از الگوریتمهای یادگیری ماشین برای یادگیری اصول اخلاقی بر اساس دادههای واقعی استفاده کنند. بدین ترتیب در شرایط پیچیده تصمیمات بهتری میگیرند. استفاده از مدلهایی که توانایی ارزیابی همزمان چندین معیار متضاد را داشته باشند (مانند نجات جان در برابر تبعات بلندمدت) و طراحی الگوریتمهایی که قوانین را به صورت سلسلهمراتبی پردازش کنند و تضادها را بر اساس اهمیت و اولویت حل کند نیز مفید خواهد بود.

آسیموف خود در داستانهایش قانون صفر را معرفی کرد که به روباتها دستور میدهد که از بشریت به عنوان یک کل یکپارچه محافظت کنند. افزودن قوانین بیشتر یا بازنگری در قوانین موجود میتواند به مدیریت بهتر تضادها کمک کند. شاید در اینجا تعریف قوانین متفاوت برای روباتهای نظامی، پزشکی، یا خدماتی که متناسب با وظایف و کاربرد آنها باشد بخش اعظم مشکلات را حل کند.

از سوی دیگر باید تلرانسی را برای خطای عملکردی روباتها در نظر گرفت. به همین روی روباتها به تنهایی نمیتوانند تمامی تضادها را به درستی مدیریت کنند. حضور و نظارت انسانی میتواند به کاهش خطاها کمک کند. روباتها باید قادر باشند در مواقع تضادهای قوانین و در شرایط بحرانی به خود انسان متوسل بشوند و از نظارت مستقیم انسانی استفاده کنند. این نظارت به کاهش ریسک تصمیمگیریهای اشتباه توسط روباتها کمک میکند. طراحی سیستمهایی که در شرایط حساس، تصمیمگیری نهایی را به انسانها واگذار کنند و شبیهسازی سناریوهای پیچیده میتواند به پیشبینی پارادوکسها و طراحی راهحلهای مناسب کمک کند. دادههای حاصل از این آزمایشها در نهایت به بهبود الگوریتمها براساس نتایج کمک میکند.

قوانین آسیموف الهامبخش مهندسان و دانشمندان در طراحی سیستمهای هوش مصنوعی و روباتیک بوده و به بحثهای اخلاقی درباره هوش مصنوعی و تأثیر آن بر انسان دامن زده است. آسیموف خلق با قوانین روباتیک، شاخهای جدید را به ژانر علمیتخیلی اضافه کرد و صدالبته دریچه تازهای را به موضوعات مهمی در حوزه علم، فلسفه و اخلاق گشود.

سه قانون روباتیک او در شرایط پیچیده، تضادها و پارادوکسهایی ایجاد میکند که نیازمند تحلیل عمیق و بازنگری است. برای مدیریت این پارادوکسها، توسعه فناوریهای پیشرفته، تعریف دقیقتر مفاهیم اخلاقی و نظارت انسانی ضروری به نظر میرسد. این قوانین اگرچه ایدهآلگرایانه هستند، اما مسیر را برای بحثهای فلسفی و علمی درباره تعامل انسان و ماشین هموار کردهاند.

انتهای پیام/